Профнастил — це популярний матеріал для покрівлі, який має міцність, довговічність і відмінні захисні властивості. Однак, щоб забезпечити довговічність і ефективний захист покрівлі, необхідно вибрати правильну товщину профнастилу.

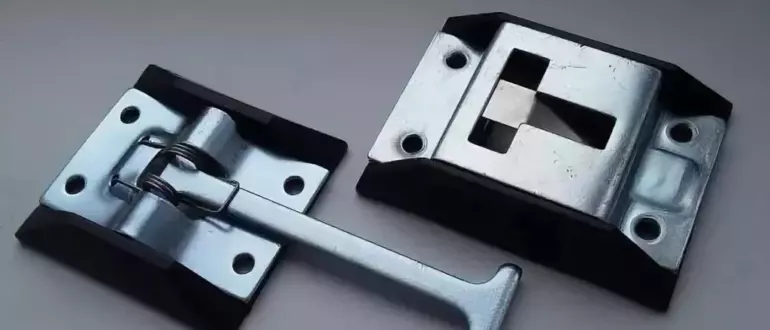

Фіксатори дверей фургона є важливим компонентом, що забезпечує безпеку вантажу та водія під час транспортування. Сьогодні фіксатор дверей фургону TIR відіграє важливу роль у запобіганні нещасним випадкам та

Твердопаливний котел – незамінна річ за умов сучасних реалій. Річ у тому, що часто такі котли і, звичайно, каміни або буржуйки, не потребують електрики та не залежать від

Как сочетать между собой модные цвета этого сезона? Все ли просто на самом деле? Осенью ка никогда хочется максимального уюта и теплоты ,нетолько на душе но и в

Вынос в натуру границ земельного участка – это важная процедура, которую необходимо провести при приобретении нового участка или при изменении границ соседних участков. Но это дело требует

Кондиционеры становятся всё более востребованными с каждым годом, так как они обеспечивают не только приятный микроклимат в доме, но и заботятся о чистоте воздуха, удаляя пыль, аллергены и

Латунные муфты — это надежные и универсальные соединительные элементы, широко используемые в различных отраслях промышленности и бытовых условиях. Сегодня муфта латунная обладает целым рядом преимуществ, которые делают их

С развитием цифровых технологий и повсеместного использования ноутбуков в нашей повседневной жизни стала актуальной проблема безопасности личной информации. Утечка данных может привести к серьезным последствиям, поэтому

В наше время стиральная машина является неотъемлемой частью быта многих семей. Она значительно облегчает процесс стирки и экономит наше время. Однако, как и любая другая техника, она иногда

Отопительные системы являются неотъемлемой частью комфортного проживания в холодные периоды года. Для обеспечения качественного отопления и горячего водоснабжения в доме важно выбрать подходящий тип котла. В последние годы